Récemment, certains membres de la communauté Slack nous ont indiqué que nos principes de confidentialité publiés en ligne n’étaient pas assez clairs et pouvaient créer des malentendus sur la manière dont nous utilisions les données des clients dans Slack. Nous apprécions ces retours et, en examinant en détail le texte sur notre site web, nous nous sommes rendu compte qu’ils avaient raison. La formulation de nos principes aurait pu être plus claire, notamment en ce qui concerne les différences d’utilisation des données pour les modèles traditionnels de machine learning et pour l’IA générative.

Aujourd’hui, nous avons mis à jour ces principes pour expliquer plus clairement comment Slack protège les données des clients tout en fournissant des expériences de ML (machine learning) et d’IA générative dans Slack. Voici ce que vous devez savoir :

- Slack utilise des techniques de machine learning conformes aux normes du secteur et qui protègent la vie privée pour des éléments comme les recommandations de canaux et d’émojis et les résultats de recherche. Nous ne créons pas et nous n’entraînons pas ces modèles de manière à ce qu’ils puissent apprendre, mémoriser ou reproduire des données clients de quelque nature que ce soit. Bien que les clients puissent se désengager, ces modèles améliorent l’expérience du produit pour les utilisateurs sans risque que leurs données soient partagées. Les modèles traditionnels de ML de Slack utilisent des données agrégées et dépersonnalisées et n’accèdent pas au contenu des messages dans les messages directs, les canaux privés ou les canaux publics.

- Le produit d’IA générative complémentaire de Slack, Slack AI, exploite des grands modèles de langage (LMM) tiers. Aucune donnée client n’est utilisée pour former les modèles LLM. Et nous ne développons pas de LLM ou d’autres modèles génératifs à l’aide de données clients.

La confiance est notre valeur première, et cela commence par la transparence. Nos clients méritent une explication claire de la manière dont nous utilisons – et, plus important encore, dont nous n’utilisons pas – leurs données pour offrir la meilleure expérience Slack possible.

Cette publication ira plus loin pour apporter encore plus de clarté. Nous espérons qu’elle vous sera utile et, comme toujours, vos retours sont les bienvenus.

Protection de vos données : l’utilisation par Slack de modèles de machine learning traditionnels

Chez Slack, notre mission est de rendre la vie professionnelle plus simple, plus agréable et plus productive. Il y a beaucoup d’informations dans Slack, et pour donner le meilleur de vous-même, vous devez être en mesure de parcourir efficacement ce contenu et de trouver ce dont vous avez besoin rapidement. Depuis 2017, nous utilisons des techniques de machine learning conformes aux normes du secteur et qui protègent la vie privée pour aider à faire apparaître les bonnes informations pour le bon utilisateur au bon moment, comme l’autocomplétion du nom d’un canal lorsque vous commencez à taper dans la recherche, ou la recommandation de nouveaux canaux à rejoindre dans votre espace de travail.

Nos Principes de confidentialité guident la façon dont nous utilisons les systèmes de machine learning dans Slack. Nous les publions en externe pour garantir transparence et responsabilité. Ces principes correspondent à l’engagement de longue date de Slack en faveur de la confidentialité des clients et des utilisateurs. Ils garantissent que :

- Les données ne passent pas d’un espace de travail à l’autre. Nous ne créons pas et nous n’entraînons pas les modèles de ML d’une manière qui leur permette d’apprendre, de mémoriser ou de reproduire les données des clients.

- Les modèles de ML n’accèdent jamais directement au contenu des messages ou des fichiers. Ils s’appuient sur des caractéristiques numériques soigneusement dérivées, par exemple :

- L’horodatage du dernier message envoyé dans un canal peut nous aider à recommander l’archivage d’un canal afin de rafraîchir les barres latérales des canaux des utilisateurs.

- Le nombre d’interactions entre deux personnes est intégré à la liste de recommandations de l’utilisateur ; ainsi, lorsqu’un utilisateur crée une nouvelle conversation, il reçoit une liste pertinente de collègues.

- Le nombre de mots identiques dans le nom d’un canal et d’autres canaux dont un utilisateur est membre peut renseigner sur la pertinence de ce premier pour l’utilisateur.

- Les contrôles techniques empêchent tout accès non autorisé. Lors du développement de modèles d’IA, de ML ou de l’analyse des données des clients, Slack n’accède pas au contenu sous-jacent. Nous avons mis en place diverses mesures techniques pour éviter que cela ne se produise. Veuillez lire notre Livre blanc sur la sécurité pour plus d’informations sur ces contrôles qui protègent la confidentialité et la sécurité des données des clients.

- Les clients ont le choix dans ces pratiques. Si vous souhaitez exclure vos données client de l’entraînement des modèles de ML de Slack, vous pouvez vous désengager, comme indiqué sur cette page. Parce que nous avons mis en place des protections robustes pour entraîner ces modèles de ML en toute sécurité afin que nous puissions fournir la meilleure expérience produit possible, les espaces de travail ne sont pas exclus par défaut.

Vous trouverez ci-dessous quelques exemples spécifiques de l’utilisation de modèles de ML non génératifs dans Slack, afin de faciliter la recherche de ce dont vous avez besoin :

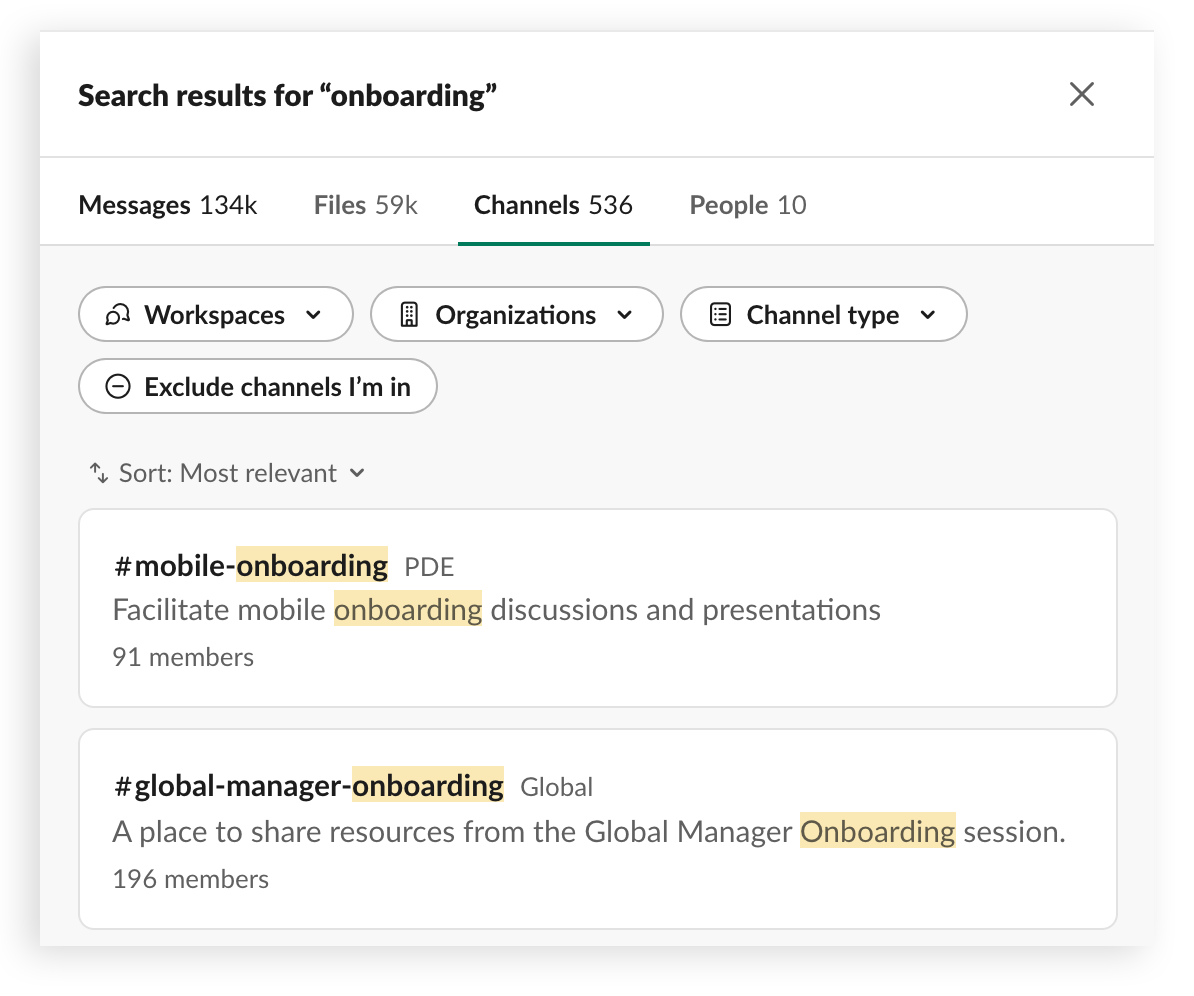

Classement des recherches

Création d’une liste de résultats hiérarchisés et personnalisés lorsqu’un utilisateur recherche des personnes, des messages ou des fichiers.

Comment ça marche :

Nos modèles de machine learning de la recherche aident les utilisateurs à trouver ce qu’ils recherchent en identifiant les bons résultats pour une requête particulière. Pour ce faire, nous nous basons sur l’historique des résultats de recherche et sur les engagements précédents, sans tirer de leçons du texte sous-jacent de la requête de recherche, du résultat ou du proxy. En d’autres termes, nos modèles ne sont pas formés à l’aide de la requête de recherche réelle, mais apprennent à partir du contexte de la recherche, tel que le nombre de mots dans une requête.

Recommandations

Recommandation d’utilisateurs, de canaux, d’émojis et d’autres contenus pertinents dans diverses parties du produit, par exemple en suggérant des canaux à rejoindre.

Comment ça marche :

Nous recommandons souvent aux utilisateurs de rejoindre de nouveaux canaux publics dans leur espace de travail afin qu’ils puissent exploiter tout le potentiel de Slack. Ces suggestions sont basées sur l’inscription aux canaux, l’activité et les correspondances de sujets. Pour ce faire, nous protégeons la vie privée en utilisant des modèles de ML open-source, qui n’ont pas été développés à partir des données de Slack, pour évaluer la similarité des sujets et produire des scores numériques. Notre modèle émet des recommandations basées uniquement sur ces scores numériques et sur les données non client.

Saisie semi-automatique

Aide à l’ajout d’utilisateurs, de canaux et de noms de fichiers dans les messages à l’aide du client de recherche Slack.

Comment ça marche :

Lorsque les utilisateurs souhaitent faire référence à un canal ou à un utilisateur dans un message, ils commencent par saisir # et le début du nom d’un canal. Nos modèles suggèrent les canaux les plus pertinents qu’ils recherchent sur la base d’un certain nombre de données, notamment les canaux dont l’utilisateur est membre et ses interactions récentes et fréquentes avec les canaux.

En résumé, les modèles de ML traditionnels de Slack utilisent des données agrégées et dépersonnalisées et n’accèdent pas au contenu des messages originaux dans les messages directs, les canaux privés ou les canaux publics pour élaborer ces suggestions. Au lieu de cela, ils collectent des données agrégées pour améliorer la recherche, déterminer de meilleures recommandations et proposer des suggestions.

Droit de rétractation du client et expérience utilisateur

Les clients peuvent envoyer un e-mail à Slack pour refuser de participer à l’entraînement de modèles de ML non génératifs. Dès lors, toutes les données associées à votre espace de travail seront utilisées pour améliorer l’expérience au sein de votre propre espace de travail. Vous continuerez à bénéficier de tous les avantages de nos modèles de ML formés à l’échelle mondiale sans contribuer aux modèles sous-jacents. Aucune fonctionnalité du produit ne sera désactivée, même si certaines parties du produit où les utilisateurs auraient pu donner leur avis seront retirées. Les modèles globaux seront probablement un peu moins performants pour votre équipe, car les modèles distincts de votre utilisation ne seront plus optimisés.

En d’autres termes, l’impact de la rétractation d’un seul client devrait être minime, mais plus le nombre de clients qui se rétractent est élevé, plus la performance globale de ces types de modèles baisse.

Voici l’IA générative

L’IA générative introduit une nouvelle classe de modèles qui sont utilisés pour améliorer l’expérience de l’utilisateur, en particulier les grands modèles de langage (LLM). Les LLM sont exploités pour le produit complémentaire de Slack, Slack AI, qui est acheté séparément. Nous avons conçu Slack AI en mettant l’accent sur la sécurité et la confiance :

- Les données clients ne quittent jamais Slack.

- Nous ne formons pas les LLM sur les données des clients.

- Slack AI n’opère que sur les données que l’utilisateur peut déjà voir.

- Slack AI répond à toutes les exigences de Slack en matière de sécurité et de conformité pour les entreprises.

Slack n’entraîne pas de LLM ou d’autres modèles génératifs à partir des données des clients et ne partage aucune donnée des clients avec des fournisseurs de LLM.

Vous pouvez en savoir plus sur la façon dont nous avons conçu Slack AI pour qu’il soit sécurisé et privé ici.