Vor Kurzem haben wir von einigen Mitgliedern der Slack-Community erfahren, dass unsere veröffentlichten Datenschutzprinzipien nicht klar genug waren und zu Missverständnissen darüber führen könnten, wie wir Daten von Kund:innen in Slack verwenden. Wir wissen das Feedback zu schätzen, und als wir uns die Formulierungen auf unserer Website angesehen haben, wurde uns klar, dass sie recht hatten. Wir hätten unseren Ansatz besser erklären können, insbesondere im Hinblick auf die Unterschiede bei der Verwendung von Daten für herkömmliche Modelle des maschinellen Lernens (ML) und generative KI.

Heute haben wir diese Prinzipien aktualisiert, um deutlicher zu erklären, wie Slack Daten von Kund:innen schützt und gleichzeitig ML- und generative KI-Erfahrungen in Slack bietet. Dies solltest du wissen:

- Slack verwendet branchenübliche ML-Techniken mit explizitem Datenschutz für Elemente wie Channel- und Emoji-Empfehlungen und Suchergebnisse. Wir erstellen oder trainieren diese Modelle nicht so, dass sie Daten von Kund:innen jeglicher Art lernen, sich merken oder reproduzieren können. Kund:innen können der Verwendung ihrer Daten zwar widersprechen, aber diese Modelle verbessern die Produkterfahrung für die Benutzer:innen, ohne dass die Gefahr besteht, dass ihre Daten jemals weitergegeben werden. Die herkömmlichen ML-Modelle von Slack verwenden aggregierte Daten, die nicht mehr identifizierbar sind, und haben keinen Zugriff auf Nachrichteninhalte in Direktnachrichten, Geschlossenen oder Offenen Channels.

- Slack AI, das Add-On-Produkt von Slack für generative KI, nutzt LLMs (Large Language Models, große Sprachmodelle) von Drittanbietenden. Es werden keine Daten von Kund:innen verwendet, um LLM-Modelle zu trainieren, und wir entwickeln keine LLMs oder andere generative Modelle mit Daten von Kund:innen.

Vertrauen ist unser höchster Wert, und das beginnt mit Transparenz. Unsere Kund:innen verdienen eine absolut transparente Erklärung dazu, wie wir ihre Daten nutzen und – was noch wichtiger ist – wie wir sie nicht nutzen, um die bestmögliche Slack-Erfahrung zu bieten.

In diesem Beitrag gehen wir noch eine Ebene tiefer, um noch mehr Klarheit zu schaffen. Wir hoffen, dass er hilfreich ist, und freuen uns wie immer über dein Feedback.

Schutz für deine Daten: Der Einsatz herkömmlicher ML-Modelle bei Slack

Slack hat es sich zur Aufgabe gemacht, das Arbeitsleben der Menschen einfacher, angenehmer und produktiver zu gestalten. Es gibt viele Informationen in Slack, und um deine Arbeit bestmöglich zu erledigen, musst du effektiv durch diese Inhalte navigieren und schnell finden können, was du brauchst. Seit 2017 nutzen wir branchenübliche ML-Techniken mit explizitem Datenschutz, um unseren Benutzer:innen zur richtigen Zeit die richtigen Informationen zu präsentieren, wie z. B. die automatische Vervollständigung eines Channel-Namens, wenn du mit der Eingabe im Suchfeld beginnst, oder die Empfehlung neuer Channels, denen du in deinem Workspace beitreten möchtest.

Unsere Datenschutzprinzipien bestimmen, wie wir ML-Systeme in Slack nutzen. Wir veröffentlichen sie extern, um Transparenz und Rechenschaft zu gewährleisten. Diese Prinzipien stehen im Einklang mit dem langjährigen Engagement von Slack für den Schutz der Daten unserer Kund:innen und Benutzer:innen. Sie stellen Folgendes sicher:

- Daten werden nicht über Workspaces hinweg übertragen. Wir erstellen oder trainieren ML-Modelle nicht auf eine Weise, die es ihnen ermöglicht, Daten von Kund:innen zu lernen, zu speichern oder zu reproduzieren.

- ML-Modelle greifen nie direkt auf den Inhalt von Nachrichten oder Dateien zu. Stattdessen arbeiten sie mit sorgfältig abgeleiteten numerischen Merkmalen. Beispiel:

- Ein Zeitstempel der letzten in einem Channel gesendeten Nachricht kann uns dabei helfen, die Archivierung eines Channels zu empfehlen, um die Channel-Seitenleisten der Benutzer:innen zu vereinfachen.

- Die Anzahl der Interaktionen zwischen zwei Personen fließt in die Empfehlungsliste ein, sodass Benutzer:innen eine relevante Liste von Kolleg:innen erhalten, wenn sie eine neue Unterhaltung beginnen möchten.

- Die Anzahl der sich überschneidenden Wörter zwischen einem Channel-Namen und anderen Channels, in denen Benutzer:innen Mitglied sind, kann Aufschluss über die Relevanz für diese Benutzer:innen geben.

- Technische Kontrollen verhindern unbefugten Zugriff. Bei der Entwicklung von KI/ML-Modellen oder der Analyse von Daten von Kund:innen greift Slack nicht auf die zugrunde liegenden Inhalte zu. Wir nutzen verschiedene technische Maßnahmen, um dies zu verhindern. Weitere Informationen zu diesen Maßnahmen, die die Vertraulichkeit und Sicherheit der Daten unserer Kund:innen schützen, findest du in unserem Whitepaper zur Sicherheit.

- Kund:innen haben bei diesen Verfahren eine Wahlmöglichkeit. Wenn du nicht möchtest, dass die Daten deiner Kund:innen beim Training der ML-Modelle von Slack verwendet werden, kannst du der Verwendung widersprechen, wie hier dokumentiert. Da wir strenge Schutzmechanismen eingerichtet haben, um diese ML-Modelle sicher zu trainieren, damit wir die bestmögliche Produkterfahrung bieten können, werden Workspaces nicht standardmäßig ausgeschlossen.

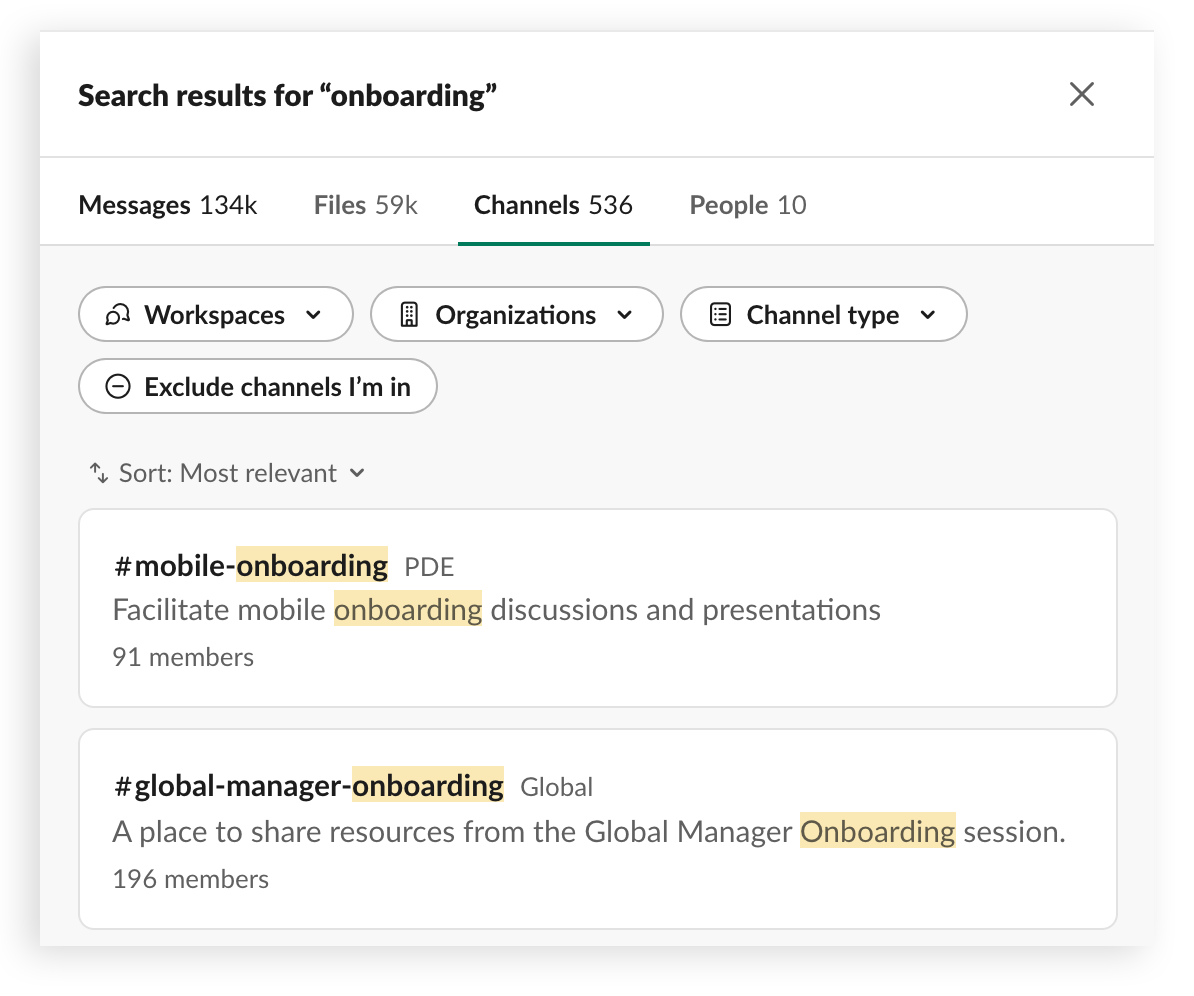

Im Folgenden findest du einige konkrete Beispiele dafür, wie nicht-generative ML-Modelle in Slack eingesetzt werden, damit du leicht findest, was du brauchst:

Suchrangliste

Erstellen einer priorisierten und personalisierten Ergebnisliste, wenn Benutzer:innen nach Personen, Nachrichten oder Dateien suchen.

So funktioniert’s:

Unsere ML-Modelle für die Suche helfen Benutzer:innen, zu finden, was sie suchen, indem sie die richtigen Ergebnisse für eine bestimmte Abfrage ermitteln. Dies erfolgt auf der Grundlage vorheriger Suchergebnisse und früherer Interaktionen, ohne dass das Modell aus dem der Suchanfrage zugrunde liegenden Text, dem Ergebnis oder dem Proxy lernt. Einfach ausgedrückt: Unsere Modelle werden nicht anhand der eigentlichen Suchabfrage trainiert, sondern lernen aus dem Kontext der Suche, z. B. aus der Anzahl der Wörter in einer Abfrage.

Empfehlungen

Das Empfehlen von relevanten Benutzer:innen, Channels, Emojis und anderen Inhalten an verschiedenen Stellen im Produkt, z. B. das Vorschlagen von Channels, denen du beitreten kannst

So funktioniert’s:

Wir empfehlen Benutzer:innen oft, neuen Offenen Channels in ihrem Workspace beizutreten, damit sie den größten Nutzen aus Slack ziehen können. Diese Vorschläge basieren auf Channel-Mitgliedschaft, Aktivität und Themenüberschneidungen. Wir tun dies auf eine datenschutzfreundliche Art und Weise, indem wir Open-Source-ML-Modelle verwenden, die überhaupt nicht mit Slack-Daten entwickelt wurden, um die Themenähnlichkeit zu bewerten und numerische Scores auszugeben. Unser Modell gibt Empfehlungen, die nur auf diesen numerischen Werten und nicht von Kund:innen stammenden Daten basieren.

Autovervollständigung

Hilfe beim Hinzufügen von Benutzer:innen, Channels und Dateinamen zu Nachrichten mit dem Slack-Such-Client.

So funktioniert’s:

Wenn Benutzer:innen in einer Nachricht auf einen Channel oder andere Benutzer:innen verweisen möchten, geben sie zuerst das Zeichen # ein und beginnen dann damit, den Namen eines Channels einzutippen. Unsere Modelle schlagen die relevantesten Channels vor, nach denen die Benutzer:innen möglicherweise suchen, und zwar basierend auf einer Reihe von Eingaben, einschließlich der Channels, in denen die Benutzer:innen Mitglied sind, und ihrer jüngsten und häufigen Channel-Interaktionen.

Zusammenfassend lässt sich sagen, dass die herkömmlichen ML-Modelle von Slack nicht mehr identifizierbare aggregierte Daten verwenden und nicht auf die ursprünglichen Nachrichteninhalte in Direktnachrichten oder Geschlossenen oder Offenen Channels zugreifen, um diese Vorschläge zu machen. Stattdessen sammeln sie aggregierte Daten, um die Suche zu verbessern, bessere Empfehlungen zu geben und Vorschläge zu machen.

Widerspruch durch Kund:innen und Benutzererfahrung

Kund:innen können Slack per E-Mail mitteilen, dass sie der Verwendung ihrer Daten für das Training nicht-generativer ML-Modelle widersprechen. Dann werden alle Daten, die mit deinem Workspace verknüpft sind, verwendet, um die Erfahrung in deinem eigenen Workspace zu verbessern. Du genießt weiterhin alle Vorteile unserer global trainierten ML-Modelle, ohne zu den zugrunde liegenden Modellen beizutragen. Es werden keine Produktfunktionen deaktiviert, allerdings werden bestimmte Stellen im Produkt entfernt, an denen Benutzer:innen zuvor Feedback geben konnten. Die globalen Modelle werden in deinem Team wahrscheinlich etwas leistungsschwächer sein, da sie nicht mehr für ausgeprägte Muster in deiner Nutzung optimiert werden.

Anders gesagt: Für einzelne Kund:innen, die widersprechen, sollte das nur minimale Auswirkungen haben, aber je mehr Kund:innen widersprechen, desto leistungsschwächer werden diese Arten von Modellen insgesamt.

Vorhang auf für generative KI

Generative KI führt eine neue Klasse von Modellen ein, die zur Verbesserung der Benutzererfahrung eingesetzt werden, insbesondere große Sprachmodelle (Large Language Models, LLMs). LLMs werden in Slack AI verwendet, dem separat zu erwerbenden Add-On-Produkt von Slack. Bei der Entwicklung von Slack AI haben wir besonderen Wert auf Sicherheit und Vertrauen gelegt, insbesondere auf Folgendes:

- Kundendaten verlassen Slack niemals.

- Wir trainieren LLMs nicht mit Kundendaten.

- Slack AI arbeitet nur mit den Daten, die Benutzer:innen bereits einsehen können.

- Slack AI wahrt sämtliche Anforderungen von Slack an Sicherheit und Compliance auf Unternehmensebene.

Slack trainiert keine LLMs oder andere generative Modelle mit Kundendaten und teilt keine Kundendaten mit LLM-Anbietern.

Hier kannst du mehr darüber lesen, wie wir Slack AI sicher und datenschutzkonform gestaltet haben.